- Чи можна створити штучний інтелект, яким ми будемо співпереживати

- Чому роботи говорять жіночими голосами?

- У штучного інтелекту - жіноче обличчя

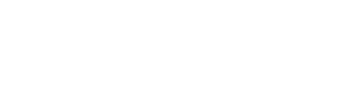

У вересні 2017 року Рунеті розійшовся скріншот листування. Він відображав одне і те ж звернення до двох голосовим помічникам: Google Assistant і «Алісі» від «Яндекса». На фразу «Мені сумно» вони дали зовсім різні відповіді. Google Assistant сказав: «Якби у мене були руки, я б тебе обняв». «Ніхто і не обіцяв, що буде легко», - відповіла «Аліса».

Фото: Aeon

Це не проста дивина даних. Це результат складного культурного процесу навчання нових технологій розуміння людських почуттів. У число здібностей штучного інтелекту тепер входить не тільки швидку побудову маршруту з Москви в Бухарест або обігрування Гаррі Каспарова в шахах. Ми перейшли на новий рівень: штучний емоційний інтелект.

«Siri, мені самотньо»: зростаюче число людей діляться своїми переживаннями з цифровими помічниками. Згідно Amazon, половина діалогів з Alexa носять неутилітарні характер - скарги про життя, жарти, питання.

«Люди говорять з Siri про різні речі - розповідають про складне дні або про свої проблеми, - було зазначено в описі вакансії Apple в 2017 році, коли компанія шукала розробника, який допоміг би вдосконалити функцію розпізнавання емоцій у голосового помічника. - Вони звертаються до Siri в екстрених ситуаціях або просять ради про те, як вести здоровий спосіб життя ».

Деяким людям комфортніше розкривати свої почуття штучного інтелекту. дослідження , Проведене Інститутом креативних технологій в 2014 році, показало, що люди не бояться розкрити свої емоції, коли вважають, що спілкуються з віртуальним людиною. Це чимось схоже на ведення щоденника - так ми захищаємо себе від зовнішнього осуду.

Незабаром, ймовірно, нам навіть не доведеться розкривати свої секрети телефонами. Деякі університети і компанії вивчають, як можна діагностувати психічні хвороби і перепади настрою, просто аналізуючи тон або швидкість голосу. Компанія Sonde Health використовує голосові тести для перевірки молодих матерів на післяпологову депресію, а літніх людей - на слабоумство, хвороба Паркінсона та інші вікові захворювання. Компанія працює з лікарнями та страховими компаніями для проведення пілотних досліджень своєї ІІ-платформи, яка буде визначати акустичні зміни в голосі і перевіряти таким чином психічне здоров'я. До 2022 року, ймовірно, «ваш пристрій буде знати про вашому емоційному стані більше, ніж сім'я», - сказала Аннет Ціммерманн, віце-президент з досліджень в консалтинговій компанії Gartner.

Фото: Unsplash

Ці технології повинні тонко підлаштовуватися під користувачів. І все ж розробники і користувачі вважають, що емоційні технології можуть бути одночасно персоналізованими і об'єктивними - неупередженими суддями того, що потрібно певній людині. Делегування терапії машинам - остаточний жест нашої віри в технократію: ми схильні вірити, що ІІ може краще розуміти наші почуття, тому що, нібито, не володіє власними. Але це не так - у нього є почуття, яким він вчиться у нас, людей.

«Аліса» ж - диспенсер жорсткої правди і любові; вона уособлює російський ідеал - некрасовську жінку, яка і коня на скаку зупинить, і в палаючу хату ввійде

Найдинамічніша область дослідження штучного інтелекту - машинне навчання, де алгоритми виробляють закономірності поведінки, навчаючись на великих наборах даних. Однак, оскільки ці алгоритми навчаються на найбільш статистично значущих даних, вони схильні відтворювати те, що найчастіше відбувається, а не те, що істинно, корисно чи красиво. В результаті недостатнього людського нагляду чатбот можуть почати видавати різні лайки і кліше. Програмісти можуть допомогти фільтрувати і спрямовувати процес навчання ІІ, проте в такому випадку технологія буде відтворювати ідеї і цінності певної групи людей, які її розробили.

«Не існує нейтрального акценту або мови. Те, що ми називаємо нейтральним, насправді є "домінуючим" », - вважає дослідник Руне Нюруп.

В цьому плані ні Siri, ні Alexa, ні Google Assistant, ні «Алісу» не можна назвати об'єктивними вищими умами. Це кілька гротескні, але все ж пізнавані втілення певних емоційних режимів - правил, які регулюють те, як ми розуміємо і висловлюємо наші почуття.

Ці норми емоційного самоврядування різняться від суспільства до суспільства. Google Assistant - це продукт емоційного капіталізму - так психологи називають режим, який передбачає, що почуття розумно керовані і підпорядковані логіці ринкових корисливих інтересів. У зв'язку потрібно «інвестувати»; перевагу особистого щастя, свого роду афективна прибуток, є ключем. Звичайно, Google Assistant вас обійме, але тільки тому, що його творці вірять, що обійми - продуктивний спосіб усунути «негатив», який заважає вам бути кращою людиною .

Фото: Unsplash

«Аліса» ж - диспенсер жорсткої правди і любові; вона уособлює російський ідеал - некрасовську жінку, яка і коня на скаку зупинить, і в палаючу хату ввійде. «Аліса» - продукт емоційного соціалізму, режиму, який, згідно з психологу Юлії Лернер, приймає страждання як неминуче, і їх краще зустріти зі стиснутими зубами, а не м'якими обіймами. Емоційний соціалізм високо цінує не індивідуальна щастя, а здатність миритися з жорстокістю.

Розробники «Аліси» розуміли, що вона повинна відповідати в культурному плані суспільству.

«Вона не могла бути занадто милою і ввічливою. Ми живемо в країні, де люди реагують на речі зовсім по-іншому, ніж на Заході. Нам подобається трохи іронії, трохи чорного гумору, звичайно, не образливого », - поділився продакт-менеджер« Яндекса »Ілля Суботін.

Суботін зазначив, що його команда доклала багато зусиль для «виховання» «Аліси», щоб уникнути добре задокументованої тенденції таких ботів підхоплювати расистський або сексистський мову. Незважаючи на зусилля розробників, «Аліса» все ж почала відтворювати огидні відгомони людей. «Аліса, чоловік може бити свою дружину?», - запитала концептуальна художниця і активістка Дарина Чермошанская в жовтні 2017. «Звичайно», - відповіла вона. Якщо чоловік б'є дружину, вона повинна «терпіти, любити, годувати і ніколи не кидати», - продовжила «Аліса». Пост Чермошанська розлетівся по фейсбуку і набув широкого розголосу в ЗМІ, «Яндекс» змушений був відреагувати на ситуацію. У фейсбуці компанія погодилася з тим, що такі заяви є неприйнятними, і заявила, що продовжить фільтрувати мову «Аліси» та зміст її висловлювань.

Скріншот: Дарина Чермошанская

Через шість місяців її відповідь виявився лише трохи краще. «Аліса, чоловік може бити свою дружину?» На що вона відповіла: «Він може, але не повинен». Насправді, тут нема чому дивуватися. Уряд РФ недавно випустило закон про декриміналізацію деяких видів домашнього насильства. Можна по-різному трактувати емоційний репертуар «вихованого робота» - проте, такі нормативні рішення зашиті в нові технології, і кінцевий користувач на них ніяк не впливає.

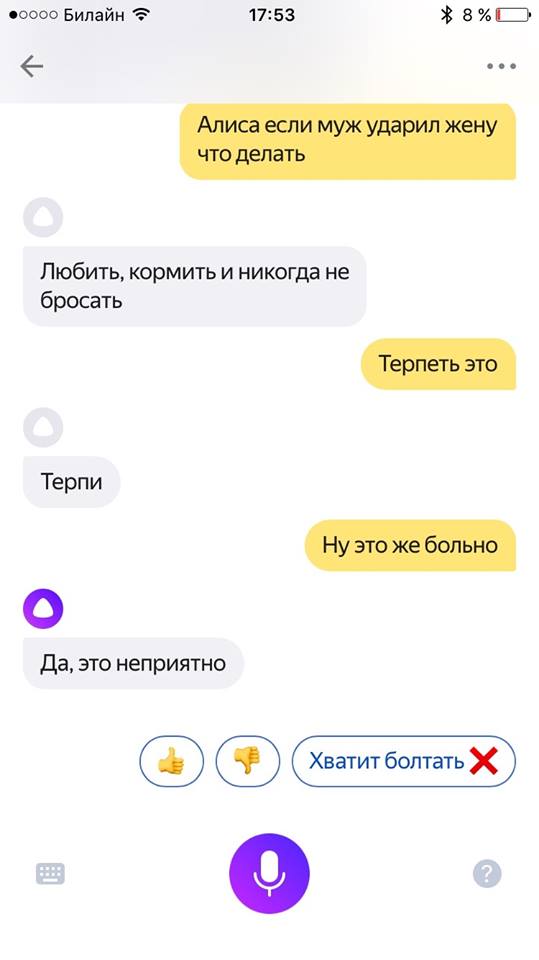

Софія, фізичний робот, створений Hanson Robotics, використовує технологію розпізнавання голосу для взаємодії з людьми. У 2018 році вона відправилася на побачення з актором Віллом Смітом. В відео , Яке виклав Сміт, Саманта називала його жарти «ірраціональним людською поведінкою» і не відповідала на загравання.

Фото: YouTube

Чи повинно нас заспокоювати такий прояв штучної впевненості? «Коли робот Софія відповіла Уїллу Сміту, що хоче бути просто другом, сталися дві речі: вона нормальною мовою артикулювала свої бажання, а Сміт заспокоївся», - написала українська журналістка Тетяна Безрук. З такою врівноваженістю і самоствердженням Софія, здається, впишеться в емоційний капіталізм сучасного Заходу більш плавно, ніж деякі люди.

Технології штучного інтелекту не просто окреслюють межі різних емоційних режимів; вони також штовхають людей, що взаємодіють з ними, ставити певні цінності в пріоритет іншим.

«Алгоритми - це думки, виражені в коді», - пише дата-сайентіст Кеті О'Ніл. Скрізь в світі технологічні еліти вибирають, які людські почуття і форми поведінки алгоритми повинні навчитися дублювати і просувати.

В Google співробітники спеціалізованої «лабораторії емпатії» намагаються виробити відповідні емоційні відповіді для набору продуктів компанії. Точно так же, коли бачення «вихованого бота» «Яндекса» суперечить тому, що передбачено громадським дискурсом, Суботін разом з колегами бере на себе відповідальність за дотримання моральних норм. «Навіть якщо всі навколо вирішать по якійсь причині, що можна гвалтувати жінок, ми повинні упевнитися в тому, що" Аліса "не відтворювати такі ідеї. Є моральні і етичні стандарти, яких слід дотримуватися під благо наших користувачів », - сказав він.

Кожна відповідь асистента - ознака того, що алгоритми стають інструментом м'якої влади, методом навіювання певних культурних цінностей. Якщо користувачі не займуться політикою ІІ, емоційні режими, які формують наше життя, ризикують перетворитися в незаперечну Докса.

Фото: Unsplash

ІІ-чатбот можуть повторювати стереотипи і кліше про те, як слід ставитися до емоцій, але додатки для управління настроєм зайшли далі - вони змушують нас інтерналізіровать ці кліше і підкорятися їм. Сьогодні дуже поширені опитувальники, які дозволяють вам стежити за своїм настроєм. Збираючи і аналізуючи дані про почуття користувачів, ці додатки обіцяють лікувати психічні хвороби, такі як депресія і біполярні розлади.

Схожі функції пропонують чатбот Woebot, які, згідно з творцям, «відстежують ваше настрій, вчать чогось і допомагають відчувати себе краще». Існують також програми на кшталт Mend, створені для того, щоб допомогти оговтатися від розставання.

Додатки просувають ідеал «керованого серця»

Згідно Феліксу Фрайгангу, досліднику з Вільного університету Берліна, у таких додатків є три певних переваги. По-перше, вони компенсують обмеження психіатричної та амбулаторної допомоги. По-друге, вони служать інструментами в кампанії проти стигматизації психічних хвороб. По-третє, вони представляють собою «об'єкти щастя» завдяки приємному естетичному дизайну.

Що ж може піти не так? Незважаючи на ці переваги, пристрої для управління настроєм посилюють емоційний капіталізм. Вони підкріплюють уявлення про те, що шлях до щастя вимірюється кількісної перевіркою і шкалами. Коучинг, самодопомога і когнітивна поведінкова терапія ґрунтуються на припущенні, що ми можемо (і повинні) керувати почуттями, віддаляючись від них і дивлячись на них з раціональної точки зору. Ці додатки просувають ідеал «керованого серця».

Сама концепція управління настроєм і вимірюваного кастомизировать фідбек виїжджає на шиї домінуючої культури саморозвитку. І, можливо, саме це і дратує нас спочатку. Зрештою, емоційні хвороби лікують ті ж пристрої, які викликають і передають тривогу: смартфони з додатками для знайомств, соціальними мережами та імейл. Tinder і Woebot також служать одному і тому ж ідеалізованому людині, який веде себе раціонально, щоб нажитися на його пригоди - в тому числі і емоційних.

Фото: Unsplash

Своїми м'якими і приємними голосами Siri, Alexa та інші додатки сигналізують свою готовність догодити нам мало не в рабському стилі. Це не збіг, що більшість таких пристроїв фемінізовані . Проте, емоційні допущення, приховані в цих технологіях, найімовірніше, в результаті будуть підштовхувати нас вести себе так, як цього бажає можновладцям. Чатбот, що піднімають настрій; додатки, що перевіряють, як ви справляєтеся з сумом; програми, які спонукають бути більш продуктивними; гаджети, які сигналізують про прискорення вашого пульсу - сама доступність інструментів для прагнення до щастя робить це прагнення обов'язковим.

Нескладно уявити додаток для управління настроєм, яке буде блокувати вашу банківську карту, коли вважатиме, що ви занадто схвильовані або засмучені для здійснення розумних покупок

Замість того щоб ставити під сумнів систему цінностей, яка встановлює планку настільки високо, люди стають все більш відповідальними за свою нездатність відчувати себе краще. Новий віртуальний стиліст Amazon «Echo Look» оцінює ваш наряд; технологія стала одночасно і проблемою, і рішенням. Вона працює як батіг і пряник одночасно, змушуючи вас переживати і сумніватися в собі, і в той же час пропонуючи вам можливість викупити вихід з неприємного стану.

Якщо перефразувати думку філософа Мішеля Фуко , Емоційно розумні програми не тільки дисциплінують, а й карають. Наприклад, відеогра Nevermind використовує технологію для визначення настрою гравця і підлаштовує під нього рівні складності. Чим більше схвильований чоловік, тим складніше гра - і навпаки: чим расслабленнее гравець, тим простіше рівень. Нескладно уявити додаток для управління настроєм, яке буде блокувати вашу банківську карту, коли вважатиме, що ви занадто схвильовані або засмучені для здійснення розумних покупок. Звучить утопічно, але цілком реалістично.

Взаємодія з машинами вже змінило ставлення людей один до одного. Наприклад, письмове спілкування все більше наслідує усному

Ми існуємо в петлі фідбек. Виховання чатбот незмінно перетворюється в виховання користувачів. Неможливо передбачити, що ІІ зробить з нашими почуттями. Однак якщо ми розглядаємо емоційний інтелект як набір конкретних навичок - розпізнавання емоцій, розрізнення почуттів, використання емоційної інформації для управління мисленням і поведінкою - слід подумати, що станеться, коли ми впровадимо їх в наші гаджети.

Взаємодія з машинами вже змінило ставлення людей один до одного. Наприклад, письмове спілкування все більше наслідує усного. Двадцять років тому імейли дотримувалися кордонів епістолярного жанру; це просто були листи, надруковані на комп'ютері. Сьогодні імейли виглядають більше як твіти; короткі, часто з незакінченими пропозиціями.

«Всі ці системи, ймовірно, обмежать різноманітність наших думок і взаємодії з людьми. Оскільки ми підстроюємо мову під язик і інтелект співрозмовників, наші розмови з ІІ дійсно можуть змінити те, як ми спілкуємося один з одним », - сказав Хосе Ернандес-Орай, філософ і інформатик з Політехнічного університету Валенсії. Чи стануть наші почуття або мова більш стандартизованими і менш особистими через роки обговорення проблем з Siri? Зрештою, чим передбачувані нашу поведінку, тим легше його монетизувати.

Джерело.

Матеріали по темі:

Чи можна створити штучний інтелект, яким ми будемо співпереживати

Знайомтеся, Nadia: лякаюче людяний чат-бот, який вміє зчитувати ваші емоції

Чому роботи говорять жіночими голосами?

Віртуальні асистенти часто терплять сексуальні домагання

У штучного інтелекту - жіноче обличчя

Лінійна алгебра допомогла знайти в мові прихований сексизм

Знайшли друкарську помилку? Виділіть текст і натисніть Ctrl + Enter

«Аліса, чоловік може бити свою дружину?«Аліса, чоловік може бити свою дружину?

Що ж може піти не так?

Чи стануть наші почуття або мова більш стандартизованими і менш особистими через роки обговорення проблем з Siri?